Во время строительства дата-центра одна из важнейших задач — решить, как отводить тепло от серверных стоек, иначе долго ЦОД не проживет. Некоторые ИТ-компании ищут поддержку у природы — рассказываем, где и как за охлаждение серверов отвечают ледяные озера и вечная мерзлота.

Скорость и безопасность работы серверов в любом дата-центре зависят от системы охлаждения. Ее мощность должна быть выше, чем суммарная мощность всего оборудования. Стандартный показатель эффективности ЦОД — коэффициент эффективности использования энергии (Power Usage Effectiveness, PUE): отношение общей мощности, потребляемой дата-центром, к мощности, потребляемой его оборудованием. Чем ниже коэффициент — тем выше эффективность. Разберем на примерах нескольких дата-центров, как организовано охлаждение с помощью природных условий.

Дата-центр в норвежских фьордах

Норвежский Lefdal Mine Datacenter может похвастаться одним из самых низких коэффициентов PUE в мире — менее 1,1, а его суммарная потребляемая мощность при этом составляет около 200 МВт.

Построенный на месте заброшенной угольной шахты, он стал «образцово-показательным» с точки зрения экологии благодаря своему расположению рядом с холодным фьордом.

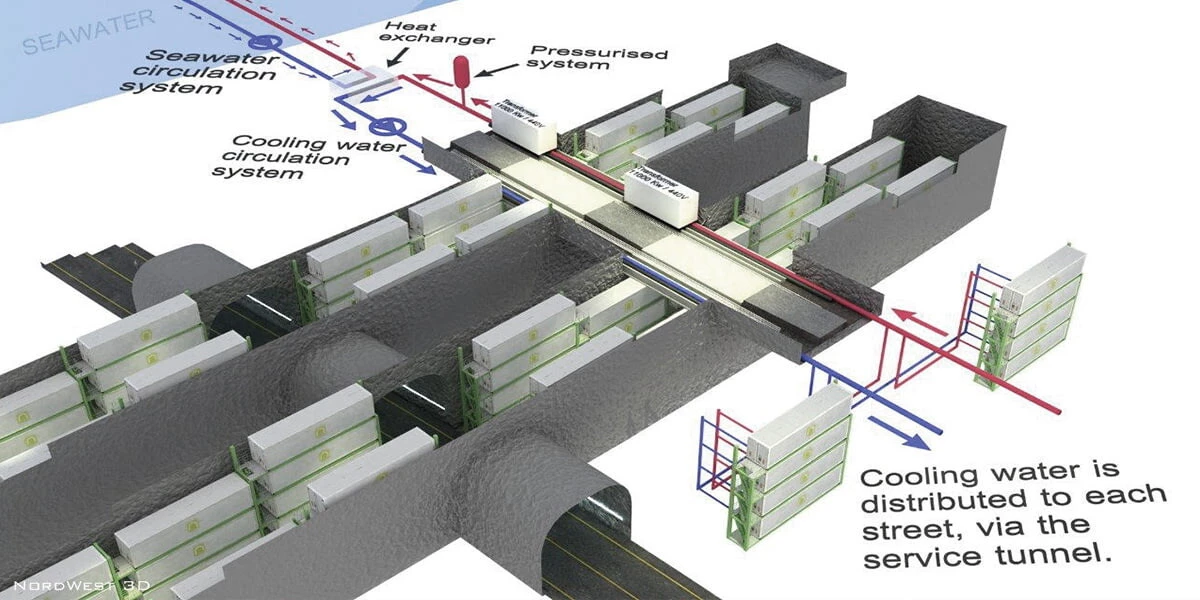

Прилегающий фьорд глубиной 565 метров обеспечивает постоянную подачу в ЦОД холодной морской воды — она забирается с глубины 80 м и откачивается на уровне моря. Температура — 7,5°С. Причем на доставку воды для системы охлаждения энергии не тратится совсем, так как штольни расположены ниже уровня моря. Нагретая до 12°С вода поступает обратно, а морские течения уносят ее, так что никакого вреда и загрязнения нет.

Схема системы охлаждения. Источник: lefdalmine.com

Cтабильный и достаточный запас энергии с нейтральным выбросом CO2 для дата-центра обеспечивает подключение к нескольким близлежащим гидроэлектростанциям. К тому же в Норвегии исторически были самые низкие цены на электроэнергию.

Рудник Лефдаль (Lefdal Mine) находится в Норвегии в регионе Вестланн. Шахта состоит из шести уровней, разделенных на 75 камер, потенциальная площадь свободного пространства —120 000 м2 .

От входа в шахту начинается «Спираль» — подъездная дорога длиной 1300 м, шириной 14 м и высотой 8,5 м. По «Спирали» можно добраться практически до каждого уровня. Центральная дорога каждого уровня называется «Авеню», а свободные площади на каждом уровне этажа являются «Улицами» и различаются по глубине (в среднем 100 метров).

В Лефдале добывали минерал оливин, но его месторождение иссякло ещё в конце ХХ века. Идею создать здесь дата-центр озвучивали много раз. Однако проект развивался медленно — менялись собственники, ответственные, партнеры. Строительство дата-центра началось только в середине 2015 года и заняло два года.

3D-тур по дата-центру. Источник: lefdalmine.com

Создатели Lefdal Mine были далеко не первыми, кто использовал фьорды для охлаждения. Ещё в 2011 году внутри горы на краю Букна-фьорд возвели ЦОД Green Mountain. Принцип работы системы охлаждения был схожим, однако показатели эффективности не столь впечатляющими.

Чем глубже — тем холоднее

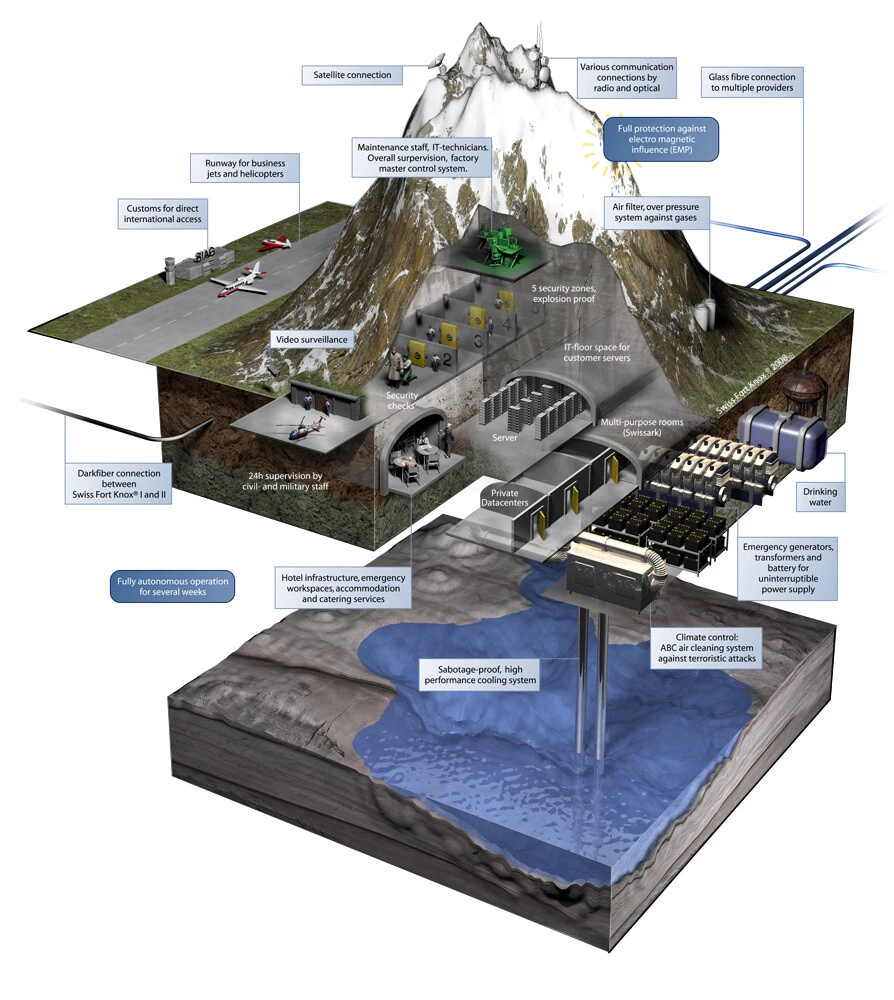

В Швейцарии тоже «привлекли» природные ресурсы к охлаждению. В регионе Бернер Оберланд в Альпах в скальном массиве расположены в 10 км друг от друга два дата-центра Mount10 — Swiss Fort Knox I и Swiss Fort Knox II. Для охлаждения всего оборудования высокопроизводительная система использует здесь подземное озеро.

Серверы спрятаны в изолированном и труднодоступном месте в самом центре Европы. Имя дата-центра перекликается с названием базы в американском штате Кентукки, где находится одно из наиболее известных в мире хранилищ золота — понятный намек на то, какой ценностью являются данные.

Дата-центр в Швейцарии. Источник: mount10.ch

Память в вечной мерзлоте

В 2017 году на месте отработанных угольных шахт на Шпицбергене был создан Всемирный арктический архив (Arctic World Archive). Хранилище расположено глубоко внутри горы — на глубине до 300 метров — на одном из островов архипелага. Здесь хранится коллекция цифровых артефактов и информации со всего мира, которую предоставили более 15 стран. В архиве нашлось место для рукописей из библиотеки Ватикана, шедевров живописи разных эпох, в том числе Рембрандта и Мунка, описаний научных открытий и современных культурных ценностей. Гарантом сохранности данных выступает вечная мерзлота: даже если в архив перестанет поступать электричество, температура внутри останется ниже температуры плавления — времени хватит как минимум на десятилетие.

Более того, специально для арктического дата-центра была разработана особая система хранения информации — носитель piqlFilm. Он будет доступен даже через тысячу лет, так как не зависит от текущего уровня технологий. Данные записываются на долговечную светочувствительную пленку в формате, похожем на QR-код. В будущем для чтения информации можно будет использовать специальные сканеры или иные устройства. По заверениям разработчиков, носитель на базе этой технологии может выдерживать экстремальное электромагнитное воздействие, так как прошел обширные испытания надежности и доступности информации на нем.

Среди «клиентов» арктического архива можно найти, например, GitHub, который разместил 6 тыс. своих наиболее важных репозиториев на неограниченный срок. Благодаря этим данным можно изучать эволюцию технологий и программного обеспечения: коллекция включает исходный код для операционных систем Linux и Android; языки программирования Python, Ruby и Rust; веб-платформы Node, V8, React и Angular; криптовалюты Bitcoin и Etherium; инструменты для разработки искусственного интеллекта TensorFlow и FastA.

Arctic World Archive. Источник: arcticworldarchive.org

Если нет под боком фьорда или ледника

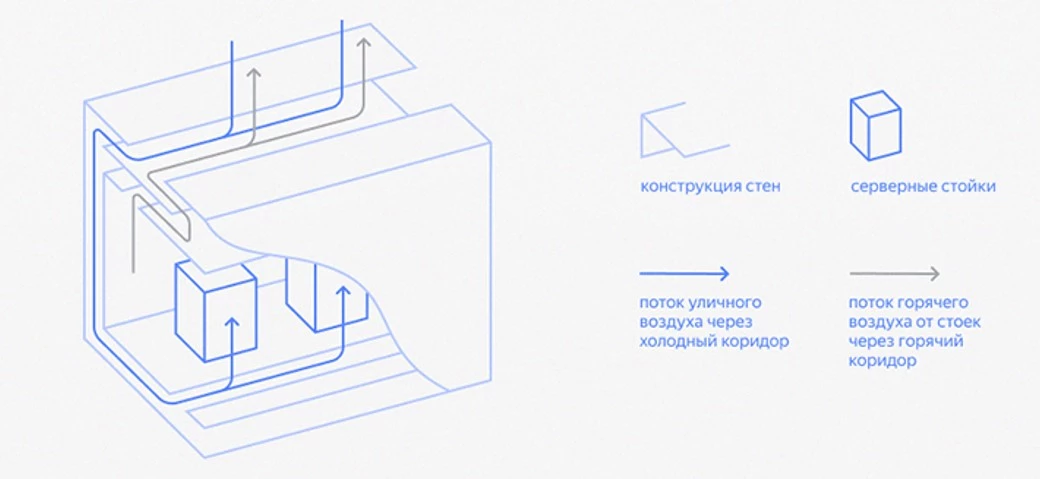

Яндекс в своих дата-центрах тоже использует концепцию фрикулинга — то есть охлаждение происходит за счет окружающей среды. В них нет сложного холодильного оборудования: серверные стойки охлаждаются уличным воздухом круглый год благодаря особому дизайну оборудования и всего ЦОДа.

Энергия в такой системе расходуется только на работу приточных вентиляторов. Через фильтры они набирают уличный воздух в холодный коридор, затем этот воздух проходит через стойки, нагревается и собирается в коллекторе. После этого часть выводится наружу вытяжными вентиляторами, а часть смешивается с воздухом снаружи — так температура держится на стабильном уровне. При температуре выше 20°С удаляется весь горячий воздух. Между воздушными массами, чтобы они двигались в нужном направлении, создаются перепады давления — например, регулируются вентиляторы притока и вытяжки и настраиваются балансировочные клапаны между горячими коридорами и горячим коллектором.

В итоге в дата-центрах в Сасово и Владимире коэффициент PUE находится в пределах 1,05-1,07, то есть эффективность использования энергии крайне высока.

Система охлаждения в дата-центрах Яндекса

Источник: vc.ru

Войдите

или зарегистрируйтесь,

чтобы поставить зачет

Комментарии 0

Войдите или зарегистрируйтесь, чтобы оставить комментарий